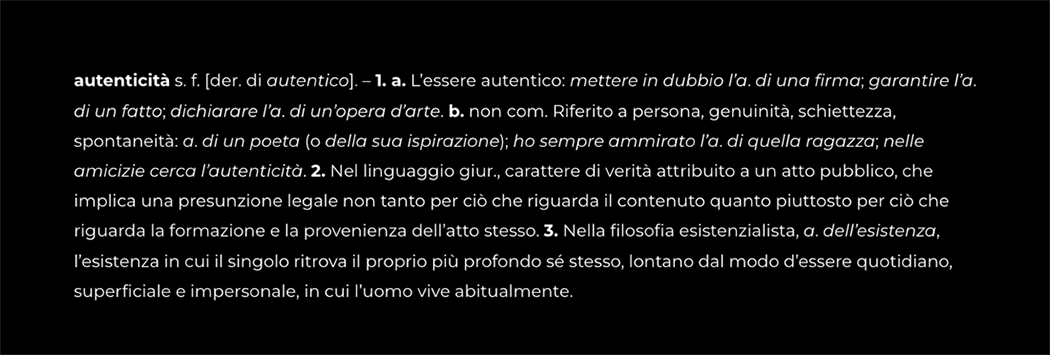

Come ci insegna il Vocabolario Treccani, l’autenticità è una forma di espressione legata a una persona, a un’opera d’arte, a un oggetto o a un fatto, o anche alla nostra stessa esistenza.

Nella odierna società digitale, ormai pervasa da sistemi e modelli di AI generativa, la verifica e asseverazione dell’autenticità è diventata un’esigenza insopprimibile da cui derivano attività complesse, delicatissime, che investono interdisciplinarmente diverse professionalità.

L’autenticità digitale scuote le nostre identità, le rappresentazioni documentali di fatti e atti, le nostre firme, le opere creative, fino a mettere a nudo le nostre emozioni e lacerazioni.

In questo numero abbiamo effettivamente affrontato la tematica più controversa e dibattuta del nostro vivere in piena digitalità, dove siamo costantemente datificati e sintetizzati, anzi ridotti, a tante piccole identità digitali, rappresentative di tracce aggregabili che abbiamo disseminato inconsapevolmente, o anche rilasciato in modo ipocritamente trasparente (perché si tratta purtroppo di trasparenza troppo spesso burocratica e svogliata).

E l’identità, la nostra identità è messa costantemente sotto scacco, sia attraverso la produzione di identità totalmente fake (sviluppate anche per scopi etici, come nel caso di Anna Luce D’Amico la prima candidata sindaco creata con l’intelligenza artificiale), sia nel caso di identità reali, ma maturate digitalmente in modo artefatto al fine di raggiungere obiettivi di varia natura (come nel caso del politico sudcoreano che ha conquistato consensi tra i più giovani grazie al suo avatar). E la stessa identità SPID sembra non passarsela così bene dal punto di vista della security, seppure su tale aspetto si avverte un po’ l’italica tendenza a fare “troppo rumore per nulla”, come ci ha anche spiegato in questo numero Claudio Anastasio.

Comunque, i rischi dell’influenza dell’IA nella formazione delle nostre coscienze sono ormai evidenti.

Da una parte, essi si insinuano attraverso una pericolosa soggettivizzazione dei sistemi di IA, che si manifesta quando attribuiamo le scelte di nostre azioni ad algoritmi “intelligenti”. Viviamo tale pericolo proprio lungo le tragedie vissute nelle recenti guerre, laddove si assegna a fredde percentuali calcolate da strumenti di intelligenza artificiale l’individuazione di potenziali bersagli, calcolati sulla base di un rischio (quello appunto di ammazzare innocenti) che dovrebbe essere inaccettabile per qualsiasi coscienza umana, ma che diventa digeribile se a compiere l’azione è una presunta intelligenza artificiale.

Dall’altra parte, lo sviluppo di nostre identità social all’interno di ecosistemi gestiti da altri, i sultani digitali che raggranellano ogni giorno ogni nostro pensiero anche più intimo, proponendoci lungo le nostre spensierate vite social ciò che è più simile a noi e più interessante per i nostri gusti e abitudini, attraverso la creazione di “echo chamber” che finiscono per radicalizzare le nostre convinzioni, portandoci irrimediabilmente a odiare chi è diverso da noi.

Siamo, infine, in un mondo che dissemina a-nazionalità sin dalle sue radici, perché il territorio si è perso nell’assenza implicita di confini del web. Qui dentro, nel mondo digitale ormai intrinsecamente correlato a quello analogico, le tutele degli ordinamenti nazionali ed europei perdono di incisività. Del resto, anche il monito autorevole di un’Authority può essere vissuto come un semplice fastidio da una società che non si riconosce in quella regolamentazione di cui si chiede il conto, semplicemente perché la sede non è in Italia o in Europa, come è capitato nello scontro tra il nostro Garante per la protezione dei dati personali e la società cinese DeepSeek. Adesso a chiedere chiarezza a DeepSeek, sempre per mancanza di trasparenza verso i suoi utenti, è un’altra Authority, Agcm. L’amara sensazione, però, è che anche in questo caso si rischi un buco nell’acqua.

Eppure, dove non c’è nazione possono esistere diritti e libertà da tutelare, nel modo in cui sta provando a spiegare un attento filosofo del diritto come Luigi Ferrajoli, il quale nei suoi più recenti contributi ci aiuta a trovare una bussola costituzionale, anche in un mondo, quello affastellato di bit, che sembra arido di democrazia sostanziale. E siamo onorati di poter annoverare il prof. Ferrajoli tra i componenti del Comitato Scientifico, qui nella nostra Rivista.

La speranza, insomma, è che sia la cultura, anche normativa, a salvarci, attraverso sintesi sistematica, collaborazioni internazionali su principi e diritti fondamentali, in modo da recuperare la custodia dei nostri dati e soprattutto di noi stessi, dei nostri valori, della nostra dignità. Perché la mancanza di trasparenza che sembra caratterizzare irrimediabilmente il world wide web, ormai straripante di social e di mirabolanti proposte di intelligenze alternative artificiali, può essere risolta.

Nel suo piccolo ruolo ritagliato in un solo anno di attività editoriale nel panorama nazionale, la Rivista Digeat vuole proprio offrire spunti interpretativi per iniziare un apprezzabile, possibile cammino di recupero di diritti e libertà fondamentali messi a dura prova nel mondo digitale, che pur guardiamo con meraviglia e attenzione. E questo importante numero, ricco di tantissimi stimoli multidisciplinari, spero che costituisca un buon inizio.

PAROLE CHIAVE: autenticità / cultura digitale / dati / informazione / verità

Tutti i contenuti presenti in questa rivista sono riservati. La riproduzione è vietata salvo esplicita richiesta e approvazione da parte dell’editore Digitalaw Srl.

Le foto sono di proprietà di Marcello Moscara e sono coperte dal diritto d’autore.